Namaste. In Berlin-Kreuzberg fand grad die Data Natives 2017 statt. Ein geniales Event! Es ging um das Danach. Was kommt nach den Digital-Natives? Es ging um Gesellschaft, Kultur, Werte, Wissenschaft. Welchen Stellenwert nehmen Daten dort ein? Workshops, Vorträge, Panel-Discussions. Alles unter dem Gesichtspunkt, dass Daten im Zentrum von allem stehen. Data-centric Point-of-View. Ich war als Speaker eingeladen. Deep-Learning. Und mein Mantra war: Time-to-Market.

Wo fange ich an?

Mein aktuelles Projekt ist das Porsche Digital Lab Berlin. Das ist eine Kooperation der MHP Management- und IT-Beratung GmbH aus Ludwigsburg und der Porsche AG aus Stuttgart. Digitalisierung ist das gemeinsame Thema. Beide Companies befassen sich im Lab mit digitalen Trends. Cloud-ready Microservices, Internet-of-Things, Blockchain und Deep-Learning, um ein paar zu nennen.

Auf der Konferenz habe ich einen Vortrag gehalten. Titel: „Deep-Learning Reflections“. Es gab viel zu erzählen. Hinter mir liegt ein gutes Jahr Deep-Learning in Berlin. Da kam einiges zusammen. Eine tief-technische Präsentation wollte ich auf der Data Natives nicht geben. Dafür gibt es meiner Meinung nach andere Formate als einen Talk. Stattdessen habe ich mich dem Storytelling hingegeben. Wunderbare 20 Minuten lang. Ein paar Anekdoten wiederhole ich in diesem Artikel.

Story of my life. I have seen things, you people wouldn’t believe.

Digital-Natives. Das sind die Menschen, die mit der Technologie aufwachsen. Generation Smartphone. Ich gehöre nicht dazu. Mein Alter war schon zweistellig, als ich meinen ersten Rechner bekam. Die Jahre davor habe ich mir die Knie blutig gemacht und habe aus dem Bach getrunken. Von Bäumen bin ich nie gefallen. Die Höhe war mir einfach zu suspekt.

Programmieren habe ich so mit sechzehn gelernt. Auf dem Dorf war die Welt noch in Ordnung. Das GW-Basic-Buch von Microsoft ist mir noch immer in bester Erinnerung. Es wurde mir mal von einem „Kumpel“ geklaut. Durch eine List bekam ich es wieder. Programmieren in den 1990er Jahren war anders als heute. Wenn ich ein Problem hatte, musste ich es alleine lösen. Und das dauerte… Stackoverflow war noch nicht mal eine Idee. Und das Internet war noch weit entfernt. Das war für mich ein kleiner Entwickler-Winter. Aber sehr lehrreich.

Eigentlich wollte ich Game-Developer werden. „Mach ein Diplom“, haben sie gesagt. „Dann kannst du mit Spielen Geld verdienen“, haben sie gesagt. In der Zeit meines Studiums ist Java schwer in Mode gekommen. Langsam kamen die ersten Laptops in den Vorlesungen an. Dann kam das Diplom. Trotzdem blieb ich an der Uni. Die Aussicht, in der Künstlichen Intelligenz zu promovieren, war charmant. Im Promotionsstudium bekam ich mein erstes Smartphone. Es liegt noch in irgendeiner Kiste. Manche Dinge behält man halt… Kurz vor dem Ende des Promotionsstudiums bin ich dann iOS-Entwickler geworden. Die Rolle hatte ich dann zwei Jahre lang bei der Volkswagen AG in Wolfsburg inne…

Ein Umweg über Ludwigsburg führte mich nach Berlin. Hier gibt es sehr viele Möglichkeiten und viel zu tun. Deshalb die Frage: Was passiert dort und welche Rolle spiele ich dabei?

Das Porsche Digital Lab Berlin.

MHP und Porsche haben es rechtzeitig erkannt. Um den Zug der Digitalisierung nicht zu verpassen, wurde die Kooperation „Porsche Digital Lab Berlin“ aus der Taufe gehoben. Es wurde ein heterogenes Team von Spezialisten nach Berlin entsandt. Der erste Punkt auf der Agenda war die Handlungsfähigkeit. Eine moderne IT-Infrastruktur wurde scharf geschaltet. Das agile Vorgehensmodell wurde an den Start gebracht. Parallel wurden auch die Kernthemen etabliert.

Nachdem wir die cloud-ready Microservices und moderne Wege der Continuous-Integration aufbereitet hatten – Pivotal Technologie! – sind wir ins Deep-Learning eingestiegen. Wegen meiner Expertise auf dem KI-Gebiet wurde ich der Topic-Owner. Am Anfang standen die ersten Artikel in der Knowledge-Base. Wissen wird im Lab gesammelt, generiert, aufbereitet, gespeichert und ständig erweitert. Danach wurden eine Deep-Learning-Technologie zur Entwicklung ausgesucht. Und hier gab es eine amtliche Auswahl an Möglichkeiten… Am Strand der Technik…

Wie sollten wir überhaupt praktisch ins Deep-Learning einsteigen? Alles selbst machen? Neuronen selber programmieren? Oder einen Baukasten benutzen und konfigurieren? Googles Tensorflow passte am besten zu unseren Requirements und Vorstellungen. Die Community war groß genug und es gab so verdammt viele Demos und erfolgreich umgesetzte Anwendungsfälle. Also legten wir mit Tensorflow los.

Deep Learning ist recht alt.

Deep-Learning ist eigentlich nichts anderes als der Umgang mit großen Neural-Networks. Diese kann man heute endlich benutzen. Das hat jahrzehntelang nicht so gut funktioniert. Warum geht das heute? Nunja… Die Datenstruktur ist für IT-Verhältnisse schon antik. Die Algorithmen gibt es auch schon eine Weile. Darüber müssen wir nicht reden. Eigentlich ein „old hat“ wie der Brite sagt…

Letztens kam es dann zu einem Boom. Und der kam mit der Erkenntnis, dass GPUs das Training massiv beschleunigen. Deswegen regnet es jetzt immer und immer wieder erfolgreiche Anwendungsfälle in der Industrie. Deswegen gibt es jeden Tag neue Papers über das nächste heiße Eisen im Feuer der Forschung.

Heute kann jeder Neural-Networks implementieren. Die Software ist da. Die Hardware ist da. Das Wissen ist da. Mit einem Dutzend Code-Zeilen ist ein Neural-Network definiert. Das war früher anders. Time-to-Market.

Zusammengefasst… Time-to-Market!

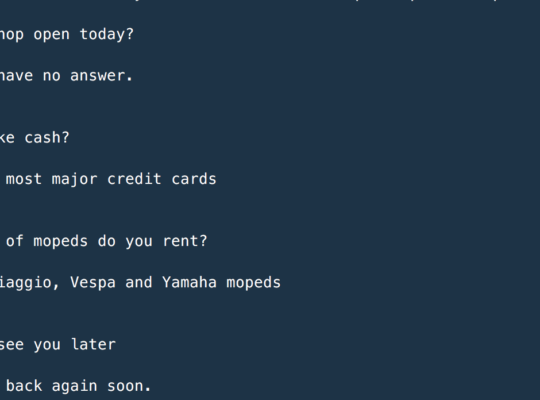

Man kann übers Wochenende Deep-Learning lernen. Das ist die Wahrheit. Nur eine Sache möchte ich nicht verschweigen. Für ein tieferes und breiteres Verständnis braucht man jedoch ein Studium. Keine Sorge, damit ist kein Master-Studiengang gemeint. Man kann das alleine lernen, wenn man Zeit und Ehrgeiz hat. Das dauert ein wenig. Oder man beschleunigt das mit entsprechenden Dienstleistern 😉

Abschließend ist zu sagen, dass jeder heute Deep-Learning lernen kann und viele es sogar lernen sollten. Die Zeiten in denen Software-Development das Umsetzen von netten reaktiven Frontends mit MySQL-Datenbankanbindung gleichzusetzen war, sind vorüber. Es wird immer mehr Deep-Learning-Projekte geben. Deep-Learning wird die ganze IT verändern. Time-to-market!